近年、芸能人、一般人問わず個人でゲーム実況や雑談などのコンテンツを配信することが増えている。また、新型コロナウイルスの影響で、イベントを開催できないアーティストなどが、ライブビデオストリーミングサービスを用いてエンタテインメントを発信するケースも増えている。このようにライブ配信の需要は増えており、現地に行くことなくエンタテインメントを享受できるライブ配信は非常に便利である。しかしながら問題点として、視聴者の一体感や臨場感が低いこと、また音楽ライブ配信やゲーム実況配信の際には、配信者は常にチャットを見ることはできないため、断片的に情報を得ることしかできないということが挙げられる。

これらの問題点に対し、本研究では参加者が配信の映像に関与することができ、かつ配信者が一目見るだけで視聴者の感情を知ることができる映像をリアルタイムに生成するインタラクティブなシステムを作り、視聴者の臨場感の向上を目指す。

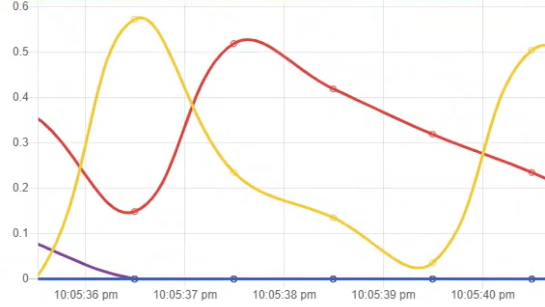

システム開発においては、視聴者が特別な知識や技能を要求せずとも使用できるチャットを用いて、映像配信中に送信されるテキストデータから取得した感情値を動的なグラフで視覚的に表現することを試みる。チャットのテキストを感情分析することで、視聴者がどのような感情でコメントをしているのかが一目見てわかるような映像をリアルタイムに生成し、その映像を配信することで、視聴者全体の感情の可視化を行い、視聴者と配信者間での双方向のコミュニケーションの実現を図る。

調査

実験では、Twitchでの配信の録画を、感情分析したグラフを表示しない場合とする場合を20代男女6名に順番に見てもらい、終了後に5段階評価によるアンケートを取った。

「チャットの感情を分析したグラフを表示する動画と表示しない動画では、どちらの方が関心をもって視聴できましたか」という質問には、「感情グラフあり」が83.3%、「どちらも同じ」が16.7%という結果になった。「チャットの感情を分析したグラフを表示することによって、動画内容のわかりやすさや臨場感は向上したと思いますか」という質問については、「そう思う」が83.3%、「とてもそう思う」が16.7%となった。「チャットの感情を分析したグラフを表示することによって、チャットの雰囲気や流れの読み取りやすさは向上したと思いますか」という質問では、全ての被験者が「そう思う」と回答した。「チャットのテキストにあった適切な感情が検出されていたと思いますか」という質問については、「どちらでもない」が50%、「そう思う」が50%となった。「どの感情が検出されているのか、グラフを見てすぐに理解することができましたか」という質問では、「どちらでもない」が16.7%、「理解できた」が33.3%、「すぐに理解できた」が50%となった。

その他感想として、「アイコンがあるともっと感情が理解しやすい」「感情の表示される動画はあまり見たことがないので面白い」「様々な感情が大きく表れている箇所は動画が盛り上がっているのが分かり良い」という意見が得られた。

研究方法

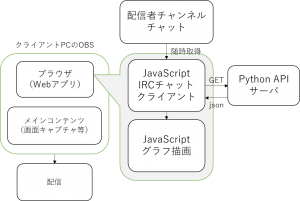

本研究で開発するシステム全体の流れを以下に示す。

本研究で対象とする配信サイトとしてTwitchを選択する。開発するシステムは、利用者である配信者への手軽さを重視し、Webアプリケーションとして実装し、Open Broad-caster Software(OBS)から本システムにアクセスすることで自動的に重畳表示することができるようなサービスを想定した。視聴者側は普段と変わらない視聴環境で視聴することができる。

感情分析の手法は主に、感情辞書ベースの手法、ディープラーニングによる手法、既存のAPIやサービスによる手法の3種類が挙げられる。感情辞書ベースの手法は単純な単語辞書レベルであればコーディングが容易であるが、厳密性を求めると複雑になり、辞書に載っていない単語があると対応できなくなるという特徴を有する。また、既存のAPIやサービスによる手法は精度が高いものの、主に企業向けのサービスとなるため使用に費用がかかるという問題がある。ディープラーニングによる手法は、コーディングが容易であるが、多くの正解データが必要であるとともにモデルがブラックボックス化してしまうという特徴がある。これらの手法の中から、本システムではディープラーニングによる手法を採用している。上述の通りブラックボックス化してしまうという特徴はあるが、未知の単語でも予測して感情値を算出できるという点が、チャットという砕けた会話で使うシステムに適していると考えた。

実装する際は、PythonのAPI サーバにAWS Lambda 等のサーバレスコンピューティングサービスを使用することを想定し、グラフを表示するサーバとの2層で開発した。クライアント側のブラウザでTwitchのIRCチャットに接続し、テキストを随時取得する。そのテキストをPythonで動かしているAPIサーバにGETメソッドで送信し、返ってきた感情値をブラウザ側でグラフ化してリアルタイムに表示する。

APIサーバに置くテキスト分類モデルの制作には、Pythonのラッパーライブラリであるktrainを使用した。ktrainを使用することで、数行のコードでGoogleの自然言語処理モデルであるBERTを実装することができる。学習済みモデルは、hugging-faceのtransformerに含まれる日本語に対応したcl-tohoku/bert-base-japaneseを使用した。教師データは長岡技術科学大学自然言語処理研究室が制作した2000語の感情語がタグ付けされているSNOW D18:日本語感情表現辞書[3]を48感情から「喜び・悲しみ・怒り・嫌悪・恐れ・驚き」の6感情に変換しタグ付けし、転移学習した。Twitchの過去配信から無作為に取得したチャットのテキストデータ1000語も自分でタグ付けしたが、モデルの正解率が大幅に下がったため、今回は除外した。

このシステムを実際に使用する際には、PC画面のキャプチャやWebカメラによる映像をメインコンテンツとして、自動生成したグラフを重畳表示して配信するため、生配信を行うためのOBSを用いて映像のミキシングを行いメインコンテンツと感情分析の結果で生成したグラフを重畳表示して配信する。

まとめ

感情分析したグラフを表示することで、配信への関心や臨場感が向上したことが分かった。また、チャットの流れを読み取りやすくなったという結果から、配信者もグラフを一目見ることで流れの速いチャットの流れをくみ取ることができると思われる。

一方で、取得したテキストからの感情検出の適切性には課題が残った。原因としては教師データが2000語と少ないこと、配信という特殊な言語でコミュニケーションする環境であること、機械学習モデルの調整が十分ではなかったことなどが挙げられる。本システムではktrainを使用して簡単に転移学習を行ったが、さらに機械学習の調整を進めることにより正解率は向上すると考えられる。

ビジュアル表現としては、シンプルな折れ線グラフだけだと細い線の色でしか感情の識別ができないので、アイコンなど他のビジュアルで表現するとより良いシステムになると考えられる。Live2D等でアニメーションを感情値に応じて自動的に動かし、顔で感情を表現するという手法も考えられる。

今回絵文字はクライアント側で除外してしまったが、本システムと併用して絵文字は辞書ベースで感情値を算出すればより良いシステムとなるだろう。

参考文献

赤澤慶一,田邊浩之,星加百合絵,

Sarah AIT HADDOU MOULOUD,垂水浩幸,林敏浩,”音楽ライブにおける遠隔地ファンとエンタテイナーのアニメーションを用いたコミュニケーション支援,エンターテインメントコンピューティングシンポジウム,(2013)

山内祟資,中野有紀子,”Twitterの感情解析に基づくTV番組シーン探索システム”, The 26th Annual Conference of the Japanese Society for Artificial Intelligence,(2012)

長岡技術科学大学 自然言語処理研究室http://www.jnlp.org/SNOW/D18(参照2021/01/17)

研究を終えて

本研究ではライブ配信における視聴者のチャットを感情分析し視覚的に表現することで臨場感を向上させる手法を検討した。その結果、6感情を動的なグラフとして表現することで、視聴者の配信への関心や臨場感が向上することが分かった。配信者においても、グラフを一目見ることでチャットの流れをくみ取ることができることが分かった。一方、グラフだけだとわかりづらいという意見もあった。それについてはアイコンなどのビジュアルで表現することが必要であると考える。